Texto universitario

_____________________________

CAPÍTULO 2. Convertir a la realidad en datos

2.1 Introducción

El enfoque estadístico supone reducir los hechos a números que puedan ser contados y dibujados en gráficos. Esto en principio podría parecer frío y deshumanizador, pero si vamos a usar la ciencia estadística para iluminar la realidad, entonces nuestras experiencias diarias tienen que convertirse en datos, y esto significa categorizar y etiquetar eventos, registrar mediciones, analizar los resultados y comunicar las conclusiones. Sin embargo, la simple categorización y el etiquetado pueden suponer un serio desafío. Tome la siguiente pregunta básica, que debería ser de interés para todos los interesados en nuestro medio ambiente: ¿Cuántos árboles hay en nuestro planeta? Antes incluso de empezar a pensar en cómo responder a esta pregunta, primero tenemos que resolver una cuestión bastante básica. ¿Qué es un árbol? Es posible que sienta que conoce un árbol cuando lo ve, pero su juicio puede diferir considerablemente de otros que podrían considerarlo un arbusto robusto. Así que para convertir la experiencia en datos, tenemos que empezar con definiciones rigurosas.

En este sentido, los investigadores por lo general toman una serie de áreas con un tipo común de paisaje, conocido como bioma y cuentan el número promedio de árboles encontrados por kilómetro cuadrado. Luego utilizando Imag2 de satélite estiman el área total del planeta cubierta por cada tipo de bioma, estos modelos estadísticos finalmente estimaron 3.04 billones de árboles en el planeta. Esto suena mucho pero en realidad solían esperar el doble de este número[1].

Los datos tienen dos limitaciones principales como fuente de tales conocimientos. En primer lugar, casi siempre es una medida imperfecta de lo que realmente nos interesa. En segundo lugar, cualquier cosa que elijamos medir diferirá de un lugar a otro, de persona a persona, y de vez en cuando, el problema es extraer ideas significativas de toda esta variabilidad aparentemente aleatoria. Durante años la ciencia estadística ha enfrentado estos desafíos, ha proporcionado la base para interpretar los datos, que siempre es imperfecta, con el fin de distinguir las relaciones importantes de la variabilidad de fondo que nos hace a todos únicos. Pero el mundo siempre está cambiando, a medida que nos hacemos nuevas preguntas, disponemos de nuevas fuentes de datos, la ciencia estadística, también ha tenido que cambiar.

Las personas siempre han medido y contado, pero las estadísticas modernas realmente nacieron como disciplina alrededor del año 1650. La probabilidad fue comprendida por Pascal y Pierre de Fermat. Dada esta sólida base matemática para hacer frente a la variabilidad, el progreso fue entonces notablemente rápido, y si además, está apoyada en la informática moderna esto potencia más su desarrollo.

Entonces en el siglo XX, las estadísticas se volvieron más matemáticas, y por desgracia, muchos estudiantes y profesionales, este tema lo convirtieron en herramientas estadísticas, y no como lo que es, argumentación estadística. La idea clásica de herramientas estadísticas se enfrenta a grandes desafíos. En primer lugar, estamos en una era de ciencias de datos, en la que se recopilan grandes conjuntos de datos y complejos monitores en tiempo real, publicaciones en redes sociales y compras en la Internet que, estas innovaciones tecnológicas reclaman optimizar algoritmos para el big data. Aunado a ello, la información estadística se ve cada vez más como un componente necesario del perfil del científico, programador, QFB, economista…, así como el conocimiento adecuado del pensamiento argumentativo basado en datos.

El uso inapropiado de métodos estadísticos estándar ha recibido una parte justa de la culpa por el abuso de métodos estadísticos sobre la ligereza de afirmar que los descubrimientos pueden ser reproducidos por otros investigadores. Lo que se ha conocido como la crisis de reproducibilidad y realización de experimentos en la ciencia[2].

Con la creciente disponibilidad de conjuntos de datos masivos y software de análisis de fácil uso, se podría pensar que hay menos necesidad de capacitar a los estudiantes en métodos estadísticos. Eso sería ingenuo en extremo. Lejos de liberarnos de la necesidad de habilidades estadísticas, datos más amplios y el aumento del número y complejidad de estudios científicos, se hace aún más difícil sacar conclusiones apropiadas. Más datos significa que tenemos que ser aún más conscientes de lo que realmente vale la evidencia en la toma de consciencia.

Las rutinas en el procesamiento de los datos, aumentan de hecho, los falsos descubrimientos, tanto debido a un sesgo sistemático inherente a las fuentes de datos como a la realización de muchos análisis en los que solo se informa lo que parece interesante, una práctica a veces conocida como “data-dredging” (degradado de datos[3]). Para poder criticar el trabajo científico publicado, o cualquier reporte que encontramos en las noticias de la noche, debemos tener en cuenta una aguda conciencia de los peligros de la presentación selectiva de informes, la necesidad de que las afirmaciones científicas sean replicadas por cuerpos de investigación independientes, y el peligro de una interpretación excesiva de un solo estudio fuera de contexto. Todas estas ideas se pueden reunir bajo el término alfabetización de datos, que describe la capacidad no solo de llevar a cabo análisis estadísticos sobre problemas del mundo real, sino también comprender y criticar cualquier conclusión extraída por otros sobre la base de la estadística. Pero mejorar la alfabetización argumentativa de la lectura significativa en la educación de las estadísticas, que debemos dar más atención a la teoría matemática que a la comprensión de fórmulas y algoritmos, el desafío es hacer las técnicas un recurso argumentativo para responder a preguntas. Por lo general educar con este enfoque, requiere ser presentado cada desafío dentro de un problema de interpretación de datos.

Generaciones de estudiantes han sufrido de cursos intensos de una estadística basada en técnicas más que en teoría matemática. La recopilación de los datos requiere el tipo de habilidades organizativas y de codificación que se consideran cada vez más importantes en la ciencia de datos, especialmente porque los datos de fuentes rutinarias pueden necesitar depuración para ser analizados. Una etapa de análisis estadístico cubre recursos técnicos analíticos para visualizar parámetros. Por último la clave de una buena ciencia estadística es extraer conclusiones apropiadas que reconozcan plenamente las limitaciones de la evidencia y la claridad de lo que comunican. Cualquier conclusión plantea más preguntas, así que el ciclo de investigación comienza de nuevo.

2.1 Comunicar recuentos y proporciones

Los datos que registran si los eventos individuales han ocurrido, son denominados datos binarios, ya que solo pueden asumir dos valores, generalmente sí o no. Los conjuntos de datos binarios se pueden resumir por el número de veces y el porcentaje de casos en los que se produjo un evento.

Una tabla se puede considerar como un tipo de gráfico y requiere cuidadosamente opciones de diseño de color, fuentes y lenguaje para garantizar la comprensión y la legibilidad. Idealmente se deben presentar marcos positivos y negativos para expresar la información imparcial, aunque el orden de interpretación es algo fortuito.

En esto hay presencia de una variable o concepto operativo. Se define como variable a cualquier medida que pueda tomar diferentes valores en diferentes circunstancias; es dentro de un corto plazo algo muy útil para todo tipo de observación que comprende datos. Las variables binarias son preguntas si/no. Las variables categóricas son medidas que pueden adoptar dos o más categorías:

Categorías no ordenadas; como el país de origen de una persona, el color de su automóvil o el hospital en el que se atendió.

Categorías ordenadas; como el grado de estudios.

Números agrupados; como niveles de temperatura, a menudo se definen en umbrales de intervalos.

Cuando se trata de presentar datos categóricos, los gráficos de círculo permiten una comprensión del tamaño de cada categoría en relación con el pastel, pero a menudo las áreas distorsionan la independencia de sus conceptos. Múltiples comparaciones es mejor presentarlas en base de alturas y longitudes de barras horizontales de las proporciones de que se trate. Por lo que sería razonable pensar que comparar proporciones es un asunto trivial. Pero cuando estas proporciones representan estimaciones de los riesgos de experimentar algún daño, entonces se hacen relevantes. Se pueden comunicar los riesgos mediante frecuencias esperadas en lugar de porcentajes o probabilidades. 1 en X es una forma de representar el riesgo, como decir 1 de cada 100 mexicanos terminará el doctorado, esto representa el 1%. Técnicamente, las probabilidades de un evento son la relación entre probabilidad de que el evento suceda contra la posibilidad de que no ocurra. Aunque son extremadamente comunes en la literatura de investigación, las relaciones de probabilidad son una manera poco intuitiva de resumir las diferencias de riesgo. Si los eventos son raros, entonces las relaciones de probabilidad estarán numéricamente cerca de los riesgos relativos.

Esto pone de relieve el peligro de utilizar las relaciones de probabilidad en cualquier cosa, y la ventaja de informar siempre de riesgos absolutos como cantidad que es relevante para una audiencia, ya sea que se trate de un contagio o cualquier otra cosa de riesgo.

Hemos intentado demostrar cómo tareas aparentemente simples de calcular y comunicar, tales como las proporciones, pueden convertirse en un asunto complejo. De llevarse a cabo con cuidado y conciencia, el impacto de los datos resumidos en parámetros numéricos o gráficos se puede explorar a través de formatos alternativos de presentar la información. La comunicación es una parte importante del ciclo de resolución de problemas y no debemos mostrar preferencias personales.

Un resumen de datos numéricos puede estar ligado a una ubicación geográfica, tendencia o correlación, están íntimamente relaciones con el cómo los datos se pueden trazar en el papel o en una pantalla. La suave transición entre simplemente reportar parámetros numéricos y tratar de contar una historia a través de una infografía.

La estadística no solo se refiere a eventos graves como el contagio de un virus o el número de cirugías de corazón. En un experimento quizá se desee probar una relación entre consumo de literatura y el declive de la violencia doméstica. Los patrones estadísticos se pueden denominar de manera diversa como distribución de los datos, distribución de muestras o de evidencia empírica. Los diagramas de puntos, simplemente muestran cada punto de datos; la gráfica de barras resume algunas cosas esenciales de la distribución de los datos. Este histograma encuentra cada uno de los intervalos como conjunto de datos, da una idea aproximada de la forma de distribución.

Estas Imag2 transmiten inmediatamente algunas características distintivas. La distribución de los datos es muy sesgada, lo que significa que ni siquiera es aproximadamente simétrica alrededor de algún valor central, y tiene un largo corrimiento por valores muy altos. Pero hay un problema con todos estos gráficos. El patrón de los puntos significa que toda la atención se centra en las conjeturas extremadamente altas, con la mayor parte de los números que se aprietan en el extremo izquierdo. ¿Podemos presentar datos de manera más informativa? Podríamos desechar valores extremadamente altos. Alternativamente podemos transformar los datos de una manera que reduzca el impacto de estos extremos, trazando en lo que se llama una escala logarítmica.

No hay una forma correcta de mostrar conjuntos de números, cada una de las gráficas que hemos citado, tiene alguna ventaja. Los gráficos de tiras muestran puntos individuales, las gráficas de cajas y los histogramas dan una buena sensación de la forma subyacente de la distribución de los datos.

Las variables que se registran como números vienen en diferentes variedades:

Variables de recuento. Donde las medidas están restringidas a los enteros 0, 1, 2…, Por ejemplo, número de egresados por año, el número de canicas en un frasco.

Variables continuas. Mediciones que se pueden realizar, al menos en principio, con precisión arbitraria. Por ejemplo, altura y peso, cada dato puede variar entre las personas.

Cuando un conjunto de recuentos u observaciones continuas se reducen a una sola estadística de resumen, esto es lo que generalmente llamamos su promedio. Todo esto se familiariza con la idea de interpretar, temperaturas o calificaciones, entre muchos otros contextos.

Hay tres interpretaciones básicas del término promedio, a veces se confunde cuando se refiere como término único al promedio, mediana y moda:

Media: la suma de los números divididos por el número de casos.

Mediana: el valor medio cuando los números se ponen en orden.

Moda: el valor más común.

2.2 Estadística

La estadística, un poeta diría: es la que nos permite mirar a través de la niebla bizarra del mundo sobre nosotros. Para comprender la realidad subyacente del significado de los datos, la estadística es una tecnología de métodos que nos permiten la extracción del significado dentro de esa niebla. La estadística es esa tecnología para el manejo de la incertidumbre, ese anhelo del hombre de predecir los eventos futuros. Las inferencias acerca de esa neblina, esas que nos arrojan datos de lo desconocido para tomar decisiones, previsiones, análisis de la dinámica de la realidad, son la tarea de las estadísticas. Pero por qué llamarla tecnología y no una disciplina científica. Una tecnología es la aplicación de los conocimientos científicos, la estadística es la aplicación del conocimiento del cómo se refiere a complementar e inferir la información en los datos de la neblina y realizar inferencias sobre sus significados. (La neblina la podemos imaginar como una nube de entropía, incertidumbre; con el potencial de transformar en información). Una estadística es un hecho numérico o resumen de análisis de datos. Así que de cierta manera un resumen de datos es el que incluye: tamaño, tasas, desviaciones, tendencias y el cómo se recopiló, manipuló, analizó y se dedujo sobre los hechos numéricos. La neblina puede ser una nube de partículas, una sociedad, el espacio climatológico, reacciones químicas, biológicas o el comportamiento de enjambres, parvadas o corrientes moleculares en un recipiente.

Los datos, es una palabra que hace énfasis en la “referencia”, significa algo dado sobre alguna parcela de la realidad y definido por conceptos operativos. Frases como: los datos nos indican; los datos demuestran; los datos muestran; los datos corroboran la teoría. Los datos son señales de algún tipo sobre algo que está fuera de nuestra mente, ese algo que está allí, con independencia y las matemáticas buscan dotarnos de un significado racional sobre eso llamado realidad. El dato tiene significado gracias al cobijo de los hechos. Un hecho es un concepto frontera entre nuestro lenguaje y la realidad, estos conceptos dan el sentido necesario a los datos, que bajo esa semántica categorizan las señales de la realidad. Cuando los datos son procesados por la estadística, se genera un producto estructurado conocido como información. La información es el paso necesario para realizar inferencias (acciones de razonamiento) y al agrupar inferencias, se produce el pensamiento abstracto que da origen al conocimiento.

Las señales de esa neblina llamada realidad, son comúnmente datos numéricos, producto de realizar ensayos de medición. En teoría, si pudiéramos realizar mediciones infinitas sobre algo, los datos significarían una versión precisa de lo que estamos observando. Mediciones infinitas, no es posible realizarlas, ya sea por cuestiones de tiempo, costo y recursos humanos o tecnológicos. Lo que representan los datos no es la imagen perfecta, no solo por estar impedidos a realizar mediciones infinitas, sino por la propia calidad del dato, toda medición se enfrenta con el error, el ruido e incertidumbre. Sin embargo, los logros asombrosos de la estadística para generar nuevo conocimiento están por todos lados en la vida moderna. Los datos en un principio, antes de ser números fueron señales de palabras, colores, sabores, emociones, sonidos, texturas, concentraciones de químicos, movimiento de partículas en el viento. El control de calidad de fármacos, refrescos, automóviles,…, en general todo producto industrial se traduce a números para expresarlo en términos de estructuras de información, es decir, en forma de gráficos, ecuaciones, señales de alerta, frases ,…

La controversia sobre las estadísticas, radica no en el procesamiento de datos, sino en cómo se utilizan las deducciones para sacar juicios a conveniencia. El papel moderno de la educación es reducir la desconfianza mediante el entendimiento del rigor de la estadística, y justamente advertir que es en la interpretación del resumen estadístico donde hay que poner atención para reconocer si hay justificación para tales inferencias. En muchos casos los reportes de investigación sustentan que comer ciertos alimentos es dañino para la salud humana, basados en juicios estadísticos. Pero el avance científico en mayor detalle dentro de la complejidad biológica pronto desmiente tales aseveraciones, no a la estadística, sino a las inferencias sobre el resumen estadístico. No es de extrañar que este oficio de las inferencias sobre resúmenes estadísticos, genere conflictos de contradicción.

2.2.1 Datos

Hemos expresado que los datos son la materia prima de la construcción de estructuras de información, son la base objetiva del resumen estadístico que normalmente se expresa en números. Los datos son el resultado de los hechos, son más que números, son el fruto del análisis conceptual de la teoría, es decir, los números deben asociarse con el significado de los hechos. No hay datos posibles que sean precisos y válidos en su calidad, si estos no están respaldados por conceptos sólidos que se justifiquen en el marco teórico. Además, los datos deben ser en muchos casos vigentes, confiables en el aspecto tecnológico de la medición y el instrumento de registro de su valor verdadero. Otra manera de mirar los datos, es considerarlos como pruebas o evidencias que dan fundamento a ideas y teorías sobre el mundo que nos rodea. Los datos son la conexión con las afirmaciones de nuestras ideas, son los que resquebrajan las viejas ideas e impulsan a las nuevas. Además, los datos no son inmunes a fallas de equipos y límites tecnológicos de los rangos de operación de instrumentos de medición, sin embargo, los datos nos dan certidumbre y tranquilidad sobre nuestras ideas que intentan ser referencia a la verdad en la realidad.

Esto implica que, para ser significativas nuestras ideas y discursos argumentales deben pasar por la verificación objetiva de referencia a los datos. Al comparar nuestros datos con las predicciones podemos confiar o razonablemente abandonar alguna teoría al demostrar su sesgo. Los datos son el camino de exploración a través de este mundo complejo, ellos guían nuestras decisiones sobre los mejores y más prometedores nichos de oportunidad. Dado el papel de los datos para justificar las ideas y la compresión del mundo.

El origen de la estadística como disciplina académica es relativamente reciente, unos doscientos años. La Royal Statistical Society (1834), sin embargo, antes de su reconocimiento académico, las primeras estadísticas nacieron en el cálculo de probabilidades en juegos de azar, por necesidad de extraer significado razonable de ellos. Otro camino surge al intentar responder a la necesidad de datos estadísticos para tomar decisiones de gobierno en materia militar, económica y cultural. Y es de esta última necesidad que surgió el nombre de estadística: “datos sobre el estado”. Todos los países modernos tienen ahora alguna institución para realizar estudios estadísticos. En el siglo XIX la estadística era un discurso de exploración sobre los datos sociales. Pero es a principios del siglo XX con la pujante Mecánica Cuántica que su cuerpo de conocimiento se desarrolló matemáticamente. Y es en los años 70’s que la estadística se vuelve emocionante al emplear en tiempo real computadoras, potenciando como nadie imaginó una gran cantidad de cálculos de manipulación aritmética que previamente hubiera llevado años, ahora se realizan en minutos. A finales del Siglo XX también se observó la aparición de analistas de datos sobre patrones de grandes volúmenes de datos. Aprender de los datos es sin duda el objetivo de la estadística, es decir, se trata de investigar dentro de lo más complejo de la neblina que llamamos realidad.

Empresas pequeñas y grandes basan en el control de calidad y la proyección del futuro de su desempeño, en el análisis de sus datos y de los de otros competidores. Estas personas no manipulan símbolos matemáticos y fórmulas, pero están usando herramientas informáticas estadísticas y métodos para obtener conocimiento y entendimiento de la evidencia de los datos. Al hacerlo, necesitan considerar una amplia gama de variables de cuestiones intrínsecamente no matemáticas, tales como la calidad de los datos, cómo fueron recogidos, definir el problema, identificar el objetivo más amplio del análisis y determinar cuánta incertidumbre se asocia con la conclusión.

La estadística es ubicua, se aplica en todos los ámbitos de la vida, esto motivó el desarrollo de métodos nuevos y herramientas estadísticas más específicas. El procesamiento de datos del ADN, partículas subatómicas y redes sociales son solo ejemplos de estos nuevos horizontes de la estadística. Los métodos estadísticos están en la esencia de la investigación científica, en las operaciones industriales, en la administración pública, en la industria, la medicina y otros aspectos de la vida social humana. El desarrollo de alimentos y medicamentos deben pasar por exhaustivas pruebas estadísticas que aseguren la inocuidad del producto y el cumplimiento de la calidad dictada por la normatividad aplicable, antes de estar en el mercado. Dado este papel fundamental, claramente es importante para los ciudadanos educados de esta manera, para ser conscientes de los instrumentos de la toma de decisiones y exploración de lo complejo. Además, la estadística moderna hace uso intensivo de software para procesar los datos, no debe vérsele como manipulación aritmética tediosa de números, este objetivo es fundamental para el interés de las jóvenes generaciones.

El problema con este punto de vista es que puede verse a la estadística como una disciplina de colección de métodos, todos ellos desconectados en la manipulación de números. Por el contrario, es un todo conectado, construido en principios profundamente filosóficos, tal como muchas ciencias lo son. Las herramientas de análisis de datos están vinculadas y relacionadas, algunas pueden incluir a otras herramientas como parte de su estructura.

Todo comenzó con la definición de dato. Piezas numéricas que describen al universo que estudiamos. Un universo es una parcela de la realidad que es inagotable en su información potencial. Podría ser una mezcla química, un sistema térmico, un sistema mecánico, transacciones de tarjetas de crédito, desempeño de lectura de estudiantes, productividad intelectual de docentes o simples lanzamientos de dados. En ellos no hay nada de particular que modifique la idea de dato. Por supuesto, una colección finita de datos no puede agotar la información contenida sobre algo que es infinito para su descripción. Eso significa que debemos ser cautos de posibles deficiencias o lagunas de los datos. Al capturar los datos debemos además de cuidar su calidad, asegurar que representan los aspectos que apoyan nuestro deseo de sacar alguna conclusión. Al capturar datos nos vemos en la necesidad de eliminar los que son irrelevantes o claramente erróneos. Producir datos está dirigido a objetivos de conocimiento y los aspectos que definen los atributos, características, funciones o aspectos técnicos del objeto de estudio a los que se les suele llamar variables. No solamente se interesa por un objeto de estudio, sino además por las relaciones entre objetos distintos. Muchos no ven los datos como la belleza del mundo, sienten que es como eliminar su poética. Pero los números tienen el potencial para poder percibir esa belleza, esa estética profunda más allá de lo subjetivo, es decir, más allá de nuestros sentidos sensoriales. Sin duda, la estadística es una forma objetiva de revelar lo profundo de sistemas altamente complejos, en los que por pereza intelectual se les suele evadir con salidas como: allí no hay más que desorden, además los números son solo un valor de magnitud. Hemos visto que los números nos dan una interfaz más directa e inmediata a los fenómenos estudiados que el discurso de palabras, porque los datos numéricos normalmente son producidos por instrumentos con más confiabilidad que nuestras palabras. Los números proceden de la cosa estudiada, mientras que las palabras son imaginación, los datos son una ventana a través de la lente de instrumentos sofisticados de medición. La propia historia de la tecnología es evidencia del arte de representar la realidad con números referidos a datos. En resumen, mientras simples números constituyen los datos, mirar su relación entre ellos y quizá combinarlos es donde surge la estadística. El análisis estadístico revela la forma en que están distribuidos estos valores. El valor representativo de la media estadística es un primer indicador de la distribución de datos.

2.2.2 Media estadística

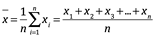

Es uno de los tipos más básicos de la descripción de datos. Es una medida de tendencia central sobre un conjunto de números. Es decir, es el promedio de una lista de números, y se hace más útil si la lista es grande. Para fines de calificación, edad o estaturas nos ayuda a tomar decisiones de en dónde está el grueso de los datos. Qué entenderemos por media estadística o media aritmética. Imagine una tabla con un millón de datos, todos ellos son el mismo número, la media aritmética se calcula más fácilmente sumando el total de los números y dividiendo este resultado entre cuántos son.

Por ejemplo, las calificaciones de un estudiante en el semestre fueron 7+9+6+4+9+10, suman 45. La media aritmética es un número de un conjunto de números, que se encuentra dividiendo a 45 entre el número total de datos, en este caso es 6. Es 7 1/2. Obtendríamos el mismo resultado si cada una de las 6 evaluaciones fueran 7 1/2, esto sería una distribución de media estadística.

Donde n es igual al número de datos, y las  son cada uno de los datos.

son cada uno de los datos.

La media aritmética siempre toma un valor entre los valores mayor y menor del conjunto de datos. Por otra parte, equilibra los números en el conjunto, en el sentido de que la suma de las diferencias entre la media aritmética y los valores más grandes, es exactamente igual a la suma de las diferencias entre la media aritmética y los valores más pequeños. En este sentido, es un valor central. La media es la distancia de un tablón desde el extremo a un pivote colocado allí y que perfectamente equilibraría el tablón. La media aritmética es una estadística. Esta resume el conjunto de valores en nuestra colección de datos, eso la hace importante.

La mediana por su parte, equilibra el conjunto de otra manera, es el valor tal que la mitad de los números en el conjunto de datos son más grandes y la mitad son menores. Por ejemplo, colocamos los datos en forma creciente del ejemplo anterior 4,5,7,9,9,10;

la mediana es el promedio de los dos valores centrales =8.

Si n es impar, la mediana es el valor que ocupa la posición (n+1)/2

Si n es par, la mediana es la media aritmética de los dos valores centrales.

La mediana es un valor estadístico representativo distinto al valor de la media. Obviamente es más fácil de calcular que la media. Pero en realidad esta ventaja si usamos una computadora, se vuelve irrelevante dado que ella absorbe el tedio de realizar los procesos aritméticos. Para elegir la utilidad de la mediana o la media, dependerá de la precisión de detalle sobre la colección de datos que estemos buscando. Si queremos precisión de la medida central usamos la media.

La media y la mediana, no son los únicos dos resúmenes estadísticos, otro importante es la moda. Es el valor tomado con mayor frecuencia en una muestra. Por ejemplo, para la colección de datos 4,5,7,9,9,10; la moda es 9.

2.2.3 Dispersión

Los promedios, como la media y la mediana, proporcionan un resumen estadístico de un solo número sobre la colección total de los datos. Son útiles porque nos dan los valores numéricos de una tendencia central. Pero esto puede ser engañoso, en particular estos valores individuales pueden diferir sustancialmente de los valores individuales en un conjunto de datos en términos de las distancias respecto a la centralidad media. Es decir, es necesario dar cuenta de lo disperso de los datos alrededor de la media. Los resúmenes estadísticos de dispersión proporcionan esta información. La medida de dispersión más simple es el rango.

El rango se define como la diferencia entre los valores mayor y menor del conjunto de datos. El rango tiene la propiedad de aportar información de la dispersión de los datos, de una manera muy sencilla. Sin embargo, se percibe que no es muy ideal. Después de todo ignora la mayoría de los datos, no puede encontrar el hecho de dónde se encuentra la mayor densidad alrededor de la media. Esta deficiencia se puede superar mediante el uso de una medida de dispersión que toma a todos los valores en cuenta.

Una forma de hacer esto, es tomar la diferencia entre la media aritmética y cada número del conjunto de datos al cuadrado y luego encontrar la media de estas diferencias cuadradas. Si la media resultante de las diferencias cuadradas es pequeña, nos dice que, en promedio los números del conjunto no son demasiado diferentes de su promedio. Es decir, ellos no son muy dispersos. Esta medida de la diferencia de cuadrados se llama varianza de los datos o desviación cuadrada media.

Una complicación surge del hecho de que la varianza implica al valor del cuadrado de los datos. La varianza es una media de los valores cuadrados. Si medimos la productividad de páginas escritas, estamos hablando del promedio de páginas cuadradas. Es obvio que no hacemos esto. Debido a esta dificultad, es común tomar la raíz cuadrada de la varianza. Esto cambia las unidades, a las unidades originales y produce la media de dispersión llamada desviación estándar. A la media se le suele conocer también como esperanza matemática, es el valor medio esperado E.

Varianza

Varianza

Desviación estándar

Desviación estándar

La desviación estándar supera el problema que identificamos con el rango, al emplear todos los datos. Esta desviación típica, si la mayoría de los datos están agrupados muy cerca, con pocos periféricos, se reconocerán por la desviación estándar pequeña. Por el contrario, si los datos toman valores muy lejanos de la esperanza matemática, los valores de la desviación estándar serán mucho mayor.

2.2.4 Oblicuidad

Si bien, las medidas de dispersión nos dicen cuánto se desvían los valores individuales de datos unos de otros. Pero no nos dicen de qué manera se desvían. En particular, no nos dicen si las desviaciones más grandes tienden a ser los valores más grandes o los valores más pequeños del conjunto de datos. Para detectar esta diferencia, necesitamos de otro resumen estadístico, uno que recoge y mide la asimetría en la distribución de valores de los datos. Un tipo de asimetría de valores se llama sesgo. Las distribuciones sesgadas son comunes. Un ejemplo clásico es la distribución de la riqueza en la sociedad, en la que la mayoría de las personas está en valores pequeños y unos cuantos en valores mayores de riqueza. Es justo por lo dispar de los sueldos. El sesgo es un estimador entre la diferencia de su media y el valor numérico del parámetro que se estima dentro de un conjunto de datos.

También se conoce como medidas de la ubicación de la distribución de datos. Interpretar el término “promedio” como el punto medio del lugar es una mala aprensión. Esto se debe a que desgraciadamente cuando se informa un promedio en los medios de comunicación, a menudo no está claro si esto debe interpretarse como la media o la mediana. No es suficiente dar un solo resumen de los datos para una distribución, necesitamos tener una idea de la propagación, a veces conocida como variabilidad. Una visión de variabilidad estadística incluye tres maneras. El rango, que es una opción natural, pero claramente muy sensible a valores extremos. En contraste, el rango intercuartil IQR no se ve afectado por los extremos. Finalmente la desviación estándar es una medida de propagación ampliamente utilizada. Es la medida técnicamente más compleja, pero solo es realmente adecuada para los datos simétricos bien comportados que también está influenciada por los valores periféricos. Esto demuestra que los datos a menudo tienen algunos errores, valores atípicos y otros valores extraños, pero esto no necesariamente necesita ser identificado y excluido individualmente.

Esto muestra que no podemos mirar los datos en su valor simplemente describiendo las diferencias entre grupos de números. Grandes colecciones de datos numéricos se resumen y comunican rutinariamente usando algunas estadísticas de ubicación y propagación, y se ha demostrado que estos no pueden llevarnos un largo camino en la comprensión de un patrón general. Para ello, es necesario una descripción de las relaciones entre variables. Es conveniente utilizar un solo número para resumir una relación de constante aumento o diminución entre pares de números que se muestran en una gráfica de dispersión. Este es generalmente elegido para ser el coeficiente de correlación de Pearson, una idea originalmente propuesta por Francis Galton pero, publicada por Karl Pearson en 1895, uno de los fundadores de las estadísticas modernas[4].

Una correlación de Pearson se ejecuta entre -1 y 1, y expresa cuán cerca de una línea recta caen los puntos o datos. Cuanto más intensa sea la concordancia (en sentido directo o inverso) de las posiciones relativas de los datos en dos variables, el producto del numerador toma mayor valor (en sentido absoluto). Si la concordancia es exacta, el numerador es igual a N (o a -N), y el índice toma un valor igual a 1 (o -1).

donde ,

son la desviación estándar de la variable x y y respectivamente.

son la desviación estándar de la variable x y y respectivamente.

La covariación  , es el grado de concordancia de las posiciones relativas de los datos de dos variables. En consecuencia, el coeficiente de correlación de Pearson opera con puntuaciones tipificadas (que miden posiciones relativas), se define:

, es el grado de concordancia de las posiciones relativas de los datos de dos variables. En consecuencia, el coeficiente de correlación de Pearson opera con puntuaciones tipificadas (que miden posiciones relativas), se define:

Una correlación de 1 ocurre si todos los puntos se encuentran en una línea recta que va hacia arriba, mientras que se produce una correlación de -1 si todos los puntos se encuentran en una línea que va hacia bajo. Una correlación cercana a 0 puede provenir de una dispersión aleatoria de puntos, o cualquier otro patrón en el que no hay una tendencia sistemática hacia arriba o hacia abajo, algunos ejemplos se muestran en la figura siguiente:

11.45.54.png)

Una medida alternativa se llama rango de correlación Spearman, por el psicólogo Charles Spearman, quien desarrolló la idea en una inteligencia subyacente, y depende de las filas de datos en lugar de valores específicos. Esto significa que pueden estar cerca de -1 o 1 si los puntos están cerca de una línea que aumenta o disminuye constantemente, incluso si esta línea no es recta[5].

donde D es la diferencia entre los correspondientes estadísticos de orden de x - y. N es el número de parejas de datos.

12.03.00.png)

El coeficiente de correlación de Spearman es menos sensible que el de Pearson para los valores muy lejos de lo esperado. En este ejemplo: Pearson = 0.30706 Spearman = 0.76270

Los coeficientes de correlación son simplemente resumen de asociación, y no se pueden utilizar para concluir que definitivamente hay una relación subyacente entre variables. En muchas aplicaciones el eje x representa una cantidad conocida como la variable independiente y el interés se centra en su influencia en la variable dependiente trazada en el eje y. Este coeficiente aún requiere estudiar más a fondo la causalidad.

Describir tendencias. Se emplea para contestar preguntas como, ¿Cuál es el patrón de crecimiento de la población mundial en el último siglo? La población del mundo está aumentando y comprender los impulsos del cambio demográfico es de vital importancia para prepararse para los desafíos que enfrentamos en el futuro. La ONU elabora estimaciones del recuento de todos los países del mundo desde 1951, junto con proyecciones útiles al año 2100[6]. Utiliza un resumen sencillo de la tendencia de cada país, en el que un aumento de 4 significa que en el 2015 hay cuatro veces más personas que en 1951. Siempre es valioso dividir los datos de acuerdo con un factor, en este caso en continentes, que explica parte de la variabilidad general. Los grandes aumentos en África se destacan, ya que hay una amplia variación en países como Costa de Marfil, que representa un caso extremo. Asia también demuestra una enorme variación, lo que refleja la amplia diversidad de países en esos continentes, con Japón y Georgia en un extremo y Arabia Saudita en el otro, con el mayor aumento reportado en el mundo. Los aumentos en Europa han sido relevantemente bajos. Como cualquier gráfico, eso plantea más preguntas y fomenta una mayor exploración, tanto en términos de identificación de países individuales, como, por supuesto, examinando las proyecciones de las tendencias futuras.

Es evidente que hay un gran número de formas de examinar un conjunto de datos tan complejo como las cifras de población de la ONU. Sin embargo, Alberto Cairo ha identificado cuatro características comunes de una buena visualización de datos[7]:

1. Contener información confiable.

2. El diseño ha sido elegido para que los patrones relevantes se vuelvan notables.

3. Se presentan de una manera atractiva, pero la apariencia no debe minar el camino de la honestidad, claridad y profundidad.

4. Cuando sea apropiado, se organiza de una manera que permita cierta exploración a las implicaciones.

La cuarta característica se puede facilitar permitiendo que el público interactúe con la visualización, como los sistemas que dispone Mathematica en línea, ver URL: https://www.wolfram.com/language/elementary-introduction/2nd-ed/preface.html.es

Pero a menudo la pregunta va más allá de la simple descripción de los datos. Queremos aprender algo más grande que las observaciones que tenemos delante, ya sea para hacer predicciones o decir algo más básico ¿Por qué están aumentando los números?

Una vez que queremos empezar a generalizar a partir de los datos, aprendemos algo sobre el mundo de nuestras observaciones inmediatas, tenemos que hacernos la pregunta ¿Aprender sobre qué? Y esto nos obliga a confrontar la difícil idea de la inferencia inductiva.

Muchas personas tienen una vaga idea de la deducción, gracias a Sherlock Holmes usando razonamiento deductivo cuando implica a un sospechoso de un crimen. En la vida real, la deducción es el proceso de utilizar las reglas de la lógica fría para trabajar desde las premisas generales hasta conclusiones particulares. Pero la inducción funciona de otra manera, al tomar casos particulares y tratar de llegar a conclusiones generales. La distinción crucial es que la deducción es lógicamente cierta, mientras que la inducción es generalmente incierta desde el punto de vista lógico y no en relación a lo que hay de conexión con lo real.

Por supuesto que sería ideal si pudiéremos pasar directamente de mirar los datos sin procesar a hacer afirmaciones generales sobre la población objetivo. En los cursos de estadística estándar, se supone que las observaciones se extraen aleatoria y directamente de la población de interés. Pero esto rara vez es el caso en la vida real, y por lo tanto, tenemos que considerar todo el proceso de pasar de los datos sin procesar a nuestro objetivo final.

Etapas

1. Los datos brutos registrados sobre los números de las variables.

2. El tamaño de muestra que nos dice algo sobre…

3. Datos de la potencial muestra en estudio …

4. Inferencias sobre la población objetivo

Pasando de los datos (Etapa 1) a la muestra (Etapa 2), estos son problemas de medición, ¿es lo que registramos en nuestros datos un reflejo preciso de lo que nos interesa? Deseamos que nuestros datos sean:

- Fiables, en el sentido de tener una razonable baja variabilidad de un caso a otro.

- Válidos, en el sentido de medir lo que realmente quieres medir, y no tener un sesgo sistemático.

Por ejemplo, en los ajustes finos en encuestas, la calidad de la encuesta también requiere que los entrevistadores sean honestos cuando reportan su actividad, no exagerar o restar importancia a sus experiencias. Una encuesta no es válida si está sesgada en una particular respuesta. Las respuestas a las preguntas también pueden verse influenciadas por lo que se ha hecho de antemano, un proceso conocido como cebado, un carácter autoinforme de la encuesta voluntaria, y el hecho de que la pregunta sea precedida por cuestiones que alteran el sentido de objetividad.

Pasando de la muestra (Etapa 2) al estudio de la población (Etapa 3), esto depende de la calidad fundamental del estudio, también conocido como validez interna, ¿refleja con precisión la muestra que observamos lo que está pasando en el grupo que realmente estamos estudiando? Aquí es donde llegamos a la manera crucial de evitar el sesgo: muestreo aleatorio. George Gallup, que esencialmente inventó la idea de la encuesta de opinión en la década de 1930, se le ocurrió una fina analogía para el valor del muestreo aleatorio[8]. Dijo que si usted ha cocinado una gran sartén de sopa, no es necesario comer todo para averiguar si necesita más condimento. Usted puede simplemente probar una cucharada, siempre que le haya dado un buen gusto. Una prueba literal de esta idea fue proporcionada por la lotería para reclutamiento en la guerra de Vietnam de 1969, que tuvo que proporcionar una lista de edades y prepararon cápsulas para contener los registros, estos destinados al azar fueron continuamente revueltos y extraídos de las cápsulas.

El hecho que tengamos masas de datos no necesariamente ayuda a garantizar una buena muestra e incluso puede dar falsa seguridad. Lo representativo está en lo aleatorio.

Pasando de la población estudiada (Etapa 3), a la población objetivo (Etapa 4) finalmente, incluso con una medición perfecta y una muestra aleatoria meticulosa, los resultados todavía pueden no reflejar lo que queríamos investigar en primer lugar si no hemos sido capaces de preguntar a las personas en las que estamos particularmente interesados en encuestas. Queremos que nuestro estudio tenga validez externa. Por ejemplo, llevar ensayos clínicos en hombres adultos, cuando el medicamento potencial se utiliza en niños y mujeres embarazadas. Nos gustaría conocer los efectos en todos, pero esto no puede resolverse solo con análisis estadístico, inevitablemente necesitamos hacer inferencias y ser muy cautelosos.

Cuando tenemos todos los datos. Aunque las ideas de aprender de los datos se ilustra cuidadosamente mirando encuestas, de hecho gran parte de estos datos no se basan en muestreo aleatorio, o de hecho en cualquier muestreo. Los datos recopilados rutinariamente Big Data, de compras en línea, de transacciones sociales, la productividad académica. En estas situaciones tenemos todos los datos disponibles. En cuanto al proceso de inducción no hay brecha entre las etapas 2 y 3. La muestra y la población del estudio son esencialmente las mismas. Esto evita cualquier preocupación acerca de tener un tamaño de muestra adecuado, pero muchos otros problemas todavía pueden permanecer.

Cuando tenemos todos los datos, es sencillo producir estadísticas que describan lo que se ha medido. Pero cuando queremos utilizar los datos para sacar conclusiones más amplias sobre lo que está sucediendo alrededor, entonces la calidad de los datos se vuelve primordial, y tenemos que estar alerta al tipo de sesgo sistemático que pueden poner en peligro la fiabilidad.

La curva en forma de campana. Ya hemos discutido el concepto de una distribución de datos, como el patrón que hacen los datos, a veces conocido como la distribución empírica o distribución de muestra. A continuación, debemos abordar el concepto de una distribución de la población, el patrón en todo el grupo de interés. Considere que una mujer mexicana acaba de dar a luz. Podríamos pensar que su bebé ha sido registrado, como una especie de muestra de una sola persona, de toda la población de bebés recién nacidos de mujeres hispanas en Canadá. Su raza es importante, ya que los pesos al nacer se reportan dependiente de las diferentes razas. La distribución de la población es el patrón hecho por los pesos al nacer de todos estos bebés, aunque este no es todo el universo de bebés contemporáneos, es una muestra tan grande que podemos tomarla como la población. Su posición en la distribución se puede considerar para evaluar si su peso es “inusual”. La forma de esta distribución es importante. Pueden considerarse cantidades continuas cuya distribución de la población es suave. El ejemplo clásico es la curva de campana o distribución normal. Explorada por primera vez por Friedrich Gauss en 1809 en el contexto de errores de medición en astronomía y topografía. La teoría muestra que se puede esperar que la distribución normal ocurra para fenómenos que son impulsados por un gran número de pequeñas influencias, por ejemplo, rasgos físicos complejos que no están influenciados por unos pocos genes.

La distribución normal se caracteriza por su media o expectativa, y su desviación estándar, que como hemos visto es una medida de dispersión, estos se reconocen como parámetros de descripción de poblaciones. Una población puede ser considerada como un grupo físico de individuos, pero también como la distribución de probabilidad para observaciones aleatorias. Esta doble interpretación será fundamental cuando lleguemos a una inferencia estadística formal.

2.2.5 ¿Qué es una población?

Las etapas de inducción anteriores funcionan muy bien con encuestas planificadas, pero una gran cantidad de análisis estadísticos no encajan tan fácilmente en este marco. Sea ha visto que, especialmente cuando utilizamos registros administrativos, policiacos sobre delitos, podemos tener todos los datos posibles. Pero aunque no haya muestreo, la idea de una población subyacente todavía puede ser valiosa. Aunque la idea de una población se establece casualmente en los cursos de estadística, hay ejemplos de otra idea sofisticada que vale la pena explorar con cierto detalle, ya que muchas ideas importantes se basan en este concepto. Hay tres tipos de poblaciones de las que se puede extraer una muestra, ya sea que los datos provengan de personas, transacciones, árboles, moléculas o cualquier otra cosa.

Una población literal. Este es un grupo identificable, como cuando elegimos una persona al azar al sondear. O puede haber un grupo de individuos que podrían ser medidos, y aunque en realidad no fueron elegidos al azar, tenemos datos de voluntarios. Por ejemplo, podríamos considerar a las personas que adivinaron el número de gomitas dentro de un frasco, como la muestra de la población de los estudiantes de matemáticas para un estudio.

Una población virtual. Con frecuencia tomamos medidas usando un dispositivo, como tomar la presión arterial o medir la humedad relativa. Sabemos que siempre podríamos tomar más medidas y obtener una respuesta ligeramente diferente, ya que sabrá si alguna vez ha tomado mediciones repetitivas, por ejemplo de la presión arterial. La cercanía de las múltiples lecturas depende de la precisión del dispositivo y la estabilidad de las circunstancias, podríamos pensar en esto como extraer observaciones de una población virtual de todas las mediciones que podríamos tomar si tuviéramos suficiente tiempo.

Una población metafórica. Cuando no hay una población más grande en lo absoluto. Es un concepto inusual. Aquí actuamos como si el punto de datos se extrajera de alguna población al azar, pero claramente no lo es, como con los niños que se someten a una cirugía, no hicimos ningún muestreo, tenemos todos los datos y no hay más que pudiéramos recopilar. Piense en el número de asesinatos que ocurren cada año, los resultados del examen para una clase en particular, o los datos sobre todos los países del mundo, ninguno de ellos puede ser considerado como una muestra de una población real.

La idea de una población metafórica es desafiante, y puede ser mejor pensar en lo que hemos observado, como haber sido extraída de algún espacio imaginario de posibilidades. Por ejemplo, la historia de la humanidad es lo que es, pero podemos imaginar que la historia ha partido de manera diferente, y resulta que hemos terminado en una de estas posibilidades de los estados del mundo. Este conjunto de todas las historias posibles puede considerarse una población metafórica.

Es evidente que pocas aplicaciones de la ciencia estadística implican realmente un muestreo aleatorio literal, y que es cada vez más común tener todos los datos que están potencialmente disponibles. Sin embargo, es extremadamente valioso mantener la idea de una población imaginaria de la que se extrae nuestra muestra, ya que entonces podemos utilizar todas las técnicas matemáticas que se han desarrollado para el muestreo de poblaciones reales.

2.3 ¿Qué causa qué?

¿Es causal de mi cobardía, mediocridad…, abandonar un libro justo en la primera página? Cuando razonar en la universidad se reflexiona, ¿es riesgo de tumor cerebral?

“La epistemología es el estudio de cómo y por qué se producen las enfermedades en la población”. Un estudio ambicioso en miles de hombres y mujeres; informa que los hombres con una posición económica más alta tenían tasa ligeramente mayor de ser diagnosticados con un tumor cerebral. Los noticieros consideran que sería mejor presentarlo diciendo: “los altos niveles de educación están vinculados a un mayor riesgo de tumor cerebral[9]”. A pesar de que claramente el estudio está dirigido al concepto operativo de nivel socioeconómico y no a la educación. Estamos en un mundo de posverdad, para cualquiera que haya pasado mucho tiempo acumulando intelecto académico, este titular podría en el noticiero resultar muy alarmante. Pero, ¿deberíamos preocuparnos? Este es un gran estudio elegante basado en un registro de la población completa, no en una muestra, por lo que podemos concluir con confianza, que en realidad se encontraron un poco más de tumores cerebrales en personas más educadas. Pero, ¿todo ese esfuerzo leyendo y escribiendo al parecer sobrecalentaba el cerebro y condujo a algunas extrañas mutaciones celulares? A pesar del titular del periódico, lo dudamos mucho. Y para darles crédito, los propios autores expresaron: “la integridad del registro y el sesgo de detección del cáncer son posibles explicaciones de los hallazgos[10]”. En otras palabras, las personas ricas con educación superior son más propensas a ser diagnosticadas y registradas con un tumor, un ejemplo de lo que se conoce como sesgo de determinación en epidemiología.

La correlación no implica causalidad, sabemos que el coeficiente de correlación de Pearson mide cuán cerca están los puntos en una gráfica de dispersión a una línea recta. Al considerar los hospitales mexicanos que atendieron COVID-19 en 2020, e intubaron los pacientes a respiradores artificiales. Se traza el número de casos contra su supervivencia, la alta correlación mostró que los hospitales más grandes estaban asociados con una menor mortalidad. Pero no se pudo concluir que los hospitales más grandes causaron la menor mortalidad. Esta es una utopía, como ejemplo.

Esta actitud cautelosa tiene una larga tradición intelectual. Cuando el coeficiente de correlación recién desarrollado por Karl Pearson estaba siendo discutido por un comité de revisores de la revista Nature en 1900, alguien advirtió que la correlación no implica causalidad. En el siglo siguiente esta frase ha sido un mantra repetidamente pronunciado por los estadísticos cuando en las aulas universitarias enseñan a ser cautos a los estudiantes con la afirmación basada en observación de dos cosas o más que tienden a viajar juntas. Incluso hay un sitio web que genera automáticamente asociaciones tan idiotas como las que expresamos en estas líneas a la ligera[11].

Parece haber una profunda necesidad humana de explicar cosas que suceden en términos de simples causas -relaciones de efecto- estamos seguros de que todos contribuimos un poco a construir mitos urbanos. Incluso hay una palabra para la tendencia a construir razones para una conexión entre lo que en realidad son eventos no relacionados -apofenia- con el caso más extremo cuando la simple desgracia se explica por la mala suerte, mala voluntad de los demás, o el cisne negro, un Déjà vu o error en la Matrix; o incluso brujería.

Desafortunadamente o tal vez, porque la educación es tan mediocre, el mundo es un poco más complicado que la simple conspiración de un genio malvado, como lo pensó Descartes. Y la primera complicación viene en tratar de averiguar lo que queremos decir con “porque”.

¿Qué es la causalidad? Es un tema profundamente cuestionado, que tal vez es sorprendente, ya que parece bastante simple en la vida real: hacemos algo, y eso conduce a otra cosa. Me martillé un dedo y ahora me duele. Pero, ¿cómo sabemos que mi pulgar no me habría dolido de todos modos? Tal vez podamos pensar en lo que se conoce como un contrafactual. Si no hubiera martillado mi pulgar con el martillo, entonces no me dolería esta tarde. Pero esto siempre será una suposición, que requiere la reescritura de la historia, ya que nunca podemos saber realmente con certeza lo que podría haber sucedido, aunque estamos “muy seguros” que no nos dolería el pulgar por propia voluntad.

Esto se vuelve aún más complicado cuando permitimos la inevitable variabilidad que subyace a todo lo interesante en la vida real. Capas subyacentes de la realidad, con independencia causal, teórica y empírica, entre lo atómico, lo molecular, lo genético, lo bioquímico, lo literario, lo cognitivo, lo gramatical, lo poético, la música, las matemáticas…, con el causal de que nuestra novia nos deje por otra persona. Por qué los científicos tardaron tanto tiempo en realizar una hipótesis deductiva entre fumar y el cáncer de pulmón; entre la violencia cruel y el bajo consumo de literatura. Por qué la mayoría de los que fuman no tienen cáncer de pulmón, y algunas de las que no fuman si lo tienen. Por qué las personas realizan actos criminales de asesinato y son grandes lectores de libros clásicos. Todo lo que podemos decir, es que es más probable tener cáncer si fumas que si no fumas, pero por qué tomó tanto tiempo a las leyes su prohibición y restringir la edad para comprar tabaco.

Así que nuestra idea de “estadística” de causalidad no es estrictamente determinista. Cuando decimos que X causa Y, no queremos decir que cada vez que ocurre X, entonces Y también. O que Y solo ocurrirá si se produce X. Simplemente queremos decir que si intervenimos y forzamos X a ocurrir, entonces Y tiende a suceder más a menudo. Así que nunca podemos decir que X causó Y en un caso específico, solo que X aumenta la proporción de veces que sucede Y. Esto tiene dos consecuencias vitales para lo que tenemos que hacer si queremos saber lo que causa qué. En primer lugar, para inferir la causalidad con verdadera confianza, lo ideal es intervenir y realizar experimentos controlados. En segundo lugar, dado que se trata de un mundo estadístico o estocástico (aquel cuyo comportamiento no es determinista), tenemos que intervenir acumulando evidencia.

Los ejemplos de correlación del tumor-intelecto, muerte COVID-tamaños de hospital, reducción de la violencia-consumo de literatura; solo pueden ser tomados en serio si cuentan con el respaldo de nueva evidencia en el largo plazo, tal como la correlación tabaco-cáncer.

Y eso nos lleva naturalmente a un tema delicado: realizar experimentos en un numeroso grupo de sujetos y objetos. Pocos de nosotros podríamos disfrutar de la idea de ser conejillos de laboratorio, especialmente cuando la vida y la muerte están presentes como opciones. Lo que hace que sea aún más notable que miles de personas han estado dispuestas a ser parte de grandes estudios científicos en los que ni ellos ni sus médicos sabían qué tratamiento terminaría recibiendo un saldo positivo. El hecho de que hay esperanza de éxito lo fue todo.

Quizá en buena medida las noticas falsas, son el reflejo de su éxito, la realidad de una educación que no enseña a pensar, sino a gritar, soy libre, pero inculto.

El objetivo de los ensayos experimentales es llevar a cabo demostraciones justificadas que determinen adecuadamente la causalidad y estime el efecto medio de un nuevo contra efecto, en el caso clínico debería obedecer a controles, ignorando la posibilidad de que cualquier relación observada no es causal en lo absoluto, es decir, resultado de la casualidad.

En la práctica, el proceso de asignación del tratamiento controlado en los ensayos experimentales, es generalmente más complejo que lo simple aleatorio, caso por caso, se asegura que los tipos de sujetos estén igualmente representados. Esta idea surgió de los experimentos agrícolas aleatorios impulsado por Ronald Fisher[12]. Un campo grande se divide en parcelas individuales, y luego a cada parcela se le asigna aleatoriamente fertilizantes diferentes, al igual que con las personas se les asigna un tratamiento al azar. Pero partes del campo podrían ser sistemáticamente diferentes debido al drenaje, la sombra, y así sucesivamente, y por lo tanto, primero el campo se dividiría en “bloques” que contienen parcelas que eran más o menos similares. La aleatorización se organiza entonces de una manera que garantice que cada bloque contenía el mismo número de parcelas dados a cada fertilizante, lo que significaría, digamos, que los tratamientos estaban equilibrados dentro de las zonas de tipo de suelo similar.

La principal innovación en experimentación aleatoria se refiere a las pruebas “A/B” en el diseño web, en las que los usuarios están (sin saberlo) dirigidos a diseños alternativos para páginas web, y mediciones realizadas sobre el tiempo invertido en las páginas, clics en enunciados, tiempo de lectura… Una serie de pruebas A/B pueden conducir rápidamente a un diseño optimizado, y los enormes tamaños de muestra significan que incluso los efectos pequeños, pero potencialmente rentables, se pueden detectar de forma confiable. Esto ha significado que una comunidad completamente nueva ha tenido que aprender a hacer comparaciones múltiples.

2.4 ¿Qué hacemos cuando no podamos aleatorizar?

Es fácil para los investigadores aleatorizar si todo lo que tienen que hacer es cambiar un sitio Web: no hay esfuerzo para reclutar ya que ni siquiera saben qué son los sujetos de un experimento y no hay necesidad de obtener la aprobación ética para usar su comportamiento dentro de las estructuras de contenido. Pero la aleatorización es a menudo difícil y a veces imposible, no podemos probar el efecto de nuestros hábitos al aleatorizar a las personas. Cuando los datos no surgen de un experimento, se dice que son observacionales. Tan a menudo nos quedamos con el mejor esfuerzo posible para ordenar la correlación de la causalidad mediante el uso de un buen diseño experimental y principios estadísticos aplicados a los datos observacionales, combinados con una dosis saludable de escepticismo.

¿Qué hacer si se observa una asociación de cosas y eventos?

Aquí es donde se requiere cierta imaginación estadística, y es un ejercicio agradable para adivinar las razones por las cuáles una correlación observada podría ser falsa. Algunas son fáciles por la estrecha correlación entre crema de coco y los ingenieros civiles, presumiblemente porque ambas medidas aumentaron con el tiempo. Del mismo modo, cualquier correlación entre las ventas de teclados y el dolor estomacal se debe a que ambos efectos están influenciados por el clima. Cuando una aparente asociación entre dos resultados puede explicarse por algún factor común observado que influye en ambos, esta causa común se conoce como un confundidor: son potenciales factores que pueden ser registrados y considerados en un análisis por su aparente referencia a los hechos.

La técnica más simple para tratar con confundidores es mirar matemáticamente la relación aparente dentro de cada nivel del factor. Esto se conoce como ajuste o estratificación. Así, por ejemplo, podríamos explorar la relación entre los ahogamientos y las ventas de helados en días con aproximadamente la misma temperatura.

Pero el ajuste puede producir algunos resultados paradójicos. En 1996, la tasa de aceptación general para estudiar cinco asignaturas académicas en Cambridge fue ligeramente mayor para los hombres (24% de 2.470 solicitantes) que para las mujeres (23% de 1.184 solicitudes). Los temas estaban todos en lo que hoy se conoce como temas STEM (ciencia, tecnología, ingeniería y medicina), que históricamente han sido estudiados predominantemente para hombres. ¿Se trata de un caso de discriminación de género? Esto se conoce como efecto Yule-Simpson o paradoja de Simpson[13], que ocurre cuando la dirección aparente de una asociación se invierte ajustándose para un factor de confusión, que requiere un cambio completo en la elección aparente de los datos. Los estadísticos se deleitan en encontrar ejemplos de esto en la vida real[14], cada uno reforzando aún más la precaución necesaria para interpretar los datos de nuestras observaciones[15].

20.10.13.png)

“Paradoja Simpson, es una paradoja en la cual una tendencia que aparece en varios grupos de datos desaparece cuando estos grupos se combinan y en su lugar aparece la tendencia contraria para los datos agregados. Esta situación se presenta con frecuencia en las ciencias sociales, en los experimentos de André y en la estadística médica,? y es causa de confusión cuando a la frecuencia de los datos se le asigna sin fundamento una interpretación causal.? La paradoja desaparece cuando se analizan las relaciones causales presentes[16]”.

En Inglaterra se dan avalúos de las casas en la correlación entre precios de la casa y la cercanía de los centros comerciales, particularmente los de lujo[17]. La correlación casi con toda seguridad refleja la política de abrir tiendas en lugares más ricos, y por lo tanto es un buen ejemplo de que la cadena de causalidad es precisamente opuesta de lo que se ha reclamado de que mayores consumidores es lo deseable. Esto se conoce, como era de esperar, como causalidad inversa. Se producen ejemplos más serios en estudios que examinan la relación entre consumo de alcohol y los resultados de salud, que generalmente encuentran que los no bebedores tienen tasas de mortalidad sustancialmente más altas que los bebedores moderados. ¿Como puede tener esto sentido dado el impacto del alcohol, por ejemplo en el hígado? Esta relación se ha atribuido parcialmente a la causalidad inversa, aquellas personas que son más propensas a morir no beben porque ya están enfermas (posiblemente a través del consumo excesivo de alcohol en el pasado). Los análisis más cuidadosos ahora excluyen a los ex bebedores, y también ignoran los acontecimientos adversos de salud en los primeros años del estudio, ya que estos pueden deberse a condiciones preexistentes[18]. Incluso con estas exclusiones, algunos beneficios generales para la salud para el consumo moderado de alcohol parecen permanecer, aunque está profundamente cuestionado[19].

¿Podemos concluir la causalidad a partir de datos observacionales?

El destacado estadístico Austin Bradford Hill, estableció los estándares para confirmar el vínculo entre el tabaquismo y el cáncer de pulmón[20]. Antes de asegurar que una exposición y un resultado era causal, se tenían que revisar los criterios sobre la evidencia directa, mecanicista y paralela[21].

Evidencia directa:

1. El tamaño del efecto es tan grande que no puede explicarse por la confusión plausible.

2. Hay proximidad temporal y/o espacial apropiada, ya que la causa precede al efecto y el efecto ocurre después de un intervalo plausible, y/o la causa ocurre en el mismo sitio que el efecto.

3. La capacidad de respuesta y reversibilidad de la dosis: el efecto aumenta a medida que aumenta la exposición, y la evidencia es aún más fuerte si el efecto se reduce. Tras la reducción de la dosis.

Evidencia mecanicista:

4. Existe un mecanismo de acción plausible, que podría ser biológico, químico o mecánico, con evidencias externas de una cadena causal.

Evidencia paralela:

5. El efecto encaja con lo que hoy se conoce.

6. El efecto se encuentra cuando se replica el estudio.

7. El efecto se encuentra en estudios similares, pero no idénticos.

Estas directrices pueden permitir que la causalidad se determine a partir de evidencias anecdóticas, incluso en ausencia de un ensayo aleatorio. Por ejemplo, se han observado úlceras bucales después de que se frota aspirina dentro de la boca, por ejemplo para aliviar el dolor dental. El efecto obedece a la directriz, ocurre donde se frota, es una respuesta plausible a un compuesto ácido, esto no es contradictorio a lo reportado por la ciencia actual y es similar al efecto conocido de la aspirina sobre el desarrollo de la úlcera estomacal, por lo que es razonable concluir que esto es una reacción adversa genuina al fármaco.

Estos criterios de Bradford Hill se aplican a las conclusiones científicas generales de las poblaciones. Pero también podemos tomar casos individuales, por ejemplo, en un litigio de responsabilidad laboral causada por riesgo de trabajo. Nunca se puede establecer con absoluta certeza que algo fue la causa por ejemplo de cáncer; ya que no se puede demostrar que el cáncer no se hubiera producido sin la exposición. Sin embargo, algunos tribunales han aceptado que, en el equilibrio de probabilidades, se ha establecido que la relación de causalidad directa sobre el riesgo relativo asociado a la explosión de algo es superior a dos %. ¿Por qué dos? Presumiblemente el razonamiento detrás de esta conclusión es que:

1. Supongamos que, en el funcionamiento normal de las cosas, de 1,000 hombres, 10 tendrían cáncer de pulmón. Si el asbesto duplica más el riesgo, si estos 1,000 hombres hubieran estado expuestos al asbesto, entonces tal vez 25 habrían desarrollado cáncer de pulmón.

2. Por lo tanto, de las personas expuestas al asbesto no desarrollan cáncer de pulmón si no hubieran estado expuestas.

3. Así que, más de la mitad de los cánceres de pulmón en este grupo habrán sido causados por el asbesto.

4. Un sujeto de este grupo de personas, entonces en el equilibrio de probabilidades su cáncer de pulmón fue causado por el asbesto.

Este tipo de argumento ha llevado a una nueva área de estudio conocida como epidemiología forense, que trata de utilizar evidencia derivada de poblaciones para sacar conclusiones sobre lo que podría haber causado eventos individuales. En efecto, esta disciplina ha sido forzada a existir por personas que buscan comprensión, pero esta es una área muy difícil para el razonamiento estadístico sobre la causalidad.

El manejo adecuado de la causalidad sigue siendo impugnado en el ámbito de las estadísticas, ya se trate de productos farmacéuticos, alimentos…, sin aleatorización, es raro poder sacar conclusiones seguras. Un enfoque imaginativo por ejemplo aprovecha que en muchos objetos de estudio está presente el hecho, por ejemplo como en los genomas, donde muchos genes se propagan esencialmente al azar a través de la población, por lo que es como si nos hayamos aleatorizado a nuestra versión específica en la confección de aleatorio. Esto se conoce como aleatorización Mendeliana[22].

Se han desarrollado otros métodos estadísticos avanzados para tratar de ajustar a los posibles confundidores, y así, acercarse a una estimación del efecto real de la exposición a algo, y estos se basan en gran medida en la idea importante del análisis de regresión. Y por eso debemos reconocer, una vez más, la fértil imaginación de Francis Galton[23].

2.5 Modelado de relaciones mediante regresión

Las ideas aquí desarrolladas, ya nos colocan en la posibilidad de visualizar asumir un único conjunto de números, y también mirar las asociaciones entre pares de variables. Estas técnicas básicas pueden llevarnos a un camino notablemente largo de especialización, pero los datos modernos generalmente serán mucho más complejos. A menudo, habrá una lista de variables posiblemente relacionadas, una de las cuales estamos particularmente interesados en explicar o predecir, si el riesgo de algo para un individuo o población produce, por ejemplo, cáncer, demencia,… Para ello es necesario un modelo estadístico de relación formal entre variables, que podemos utilizar para explicar o predecir. Eso significa inevitablemente introducir algunas ideas matemáticas, pero los conceptos básicos deben ser claros sin usar cálculos de álgebra.

Pero primero volvamos a Francis Galton. Tenía el interés obsesivo del clásico caballero victoriano científico en recopilar datos y obtener la sabiduría, por ejemplo, sobre el peso de un buey. Utilizó sus observaciones para hacer pronósticos meteorológicos, para evaluar la eficacia de las sentencias e incluso para comparar la belleza relativa de las mujeres jóvenes en diferentes regiones en su país. También compartió la fijación de su primo Charles Darwin por la herencia, trató de investigar los cambiando de rasgos entre generaciones. Estaba particularmente interesado en la siguiente pregunta:

Usando las estaturas de sus padres, ¿cómo podemos predecir la altura de una descendencia adulta?

Queremos una línea para predecir la altura de un hijo desde la de sus padres. Queremos una línea que haga de las desviaciones a los datos algo pequeños, y la técnica estándar es elegir una línea ajustada de mínimos cuadrados, para la cual la suma de los cuadrados de los desvíos es la más pequeña. La fórmula para esta línea es sencilla y fue desarrollada por Adrien-Marie Legendre y Carl Friedrich Gauss a finales del siglo XVIII. La línea es generalmente conocida como predicción del mejor ajuste.

En el análisis de regresión básico, la variable dependiente es la cantidad que queremos predecir o explicar, normalmente formando el eje Y vertical de un gráfico, esto a veces se conoce como la variable de respuesta. Mientras que la variable independiente es la cantidad que usamos para hacer la predicción o explicación, generalmente formando el eje X horizontal de un gráfico, y a veces conocida como variable explicativa. El gradiente también se reconoce como coeficiente de regresión. Hay una relación simple entre los gradientes (o tasa de cambio), el coeficiente de correlación de Pearson y las desviaciones estándar de las variables. De hecho si las desviaciones estándar de las variables independientes y dependientes son las mismas, entonces el gradiente es simplemente la correlación del coeficiente de Pearson, que explica su similitud.

El significado de estos gradientes depende completamente de nuestras suposiciones sobre la relación entre las variables que se están estudiando. Para los datos de correlación, el gradiente indica cuánto esperamos que la variable dependiente cambiará, en promedio, si observamos una diferencia de una unidad para la variable independiente. Por su puesto, que no esperamos que esta predicción coincida con su verdadera diferencia de estaturas de nuestro problema, pero es la mejor conjetura que podemos hacer con los datos disponibles.

Sin embargo, si asumimos una relación causal, entonces el gradiente tiene una interpretación diferente, es el cambio que esperaríamos en la variable dependiente si interviniéramos y cambiáramos la variable independiente a un valor de una unidad más alta. Los estadísticos son reacios a considerar atribuir causalidad a menos que haya habido un experimento, aunque la informática ha hecho grandes progresos en fijar algunos principios para construir modelos de regresión causal a partir de datos observacionales.

Las líneas de regresión son modelos que encajan entre un aspecto del mundo que se basa en la simplificación de los supuestos. Esencialmente algún fenómeno estará representado matemáticamente, generalmente incrustado en el software, con el fin de producir una versión simplificada de la realidad, pretendiendo predecir su comportamiento.

Los modelos estadísticos tienen dos componentes principales. En primer lugar, una fórmula matemática que expresa un componente determinista y predecible, por ejemplo, la línea recta ajustada que nos permite hacer predicciones de la altura de un hijo desde la de sus padres. Pero la parte determinista de un modelo no va a ser una representación perfecta del mundo observado. Hay dispersión de alturas alrededor de la línea de regresión, y la diferencia entre lo que el modelo predice, y lo que realmente sucede, es el segundo componente del modelo, y se le conoce como el error residual, aunque es importante recordar que en el modelo estadístico, el “error” no se refiere a un error, sino a la inevitable incapacidad de un modelo para representar exactamente lo que observamos. Así que en resumen, asumimos que:

Observación = modelo determinista + error residual

Esta fórmula se interpreta diciéndonos que, en el mundo estadístico, lo que vemos y medimos a nuestro alrededor, puede ser considerado como una suma de una forma idealizada matemática sistemática, más alguna contribución aleatoria que aún no se puede explicar. Esta es la idea clásica de la señal y el ruido en la instrumentación y las telecomunicaciones. Solo porque actuamos, y algo cambia, no significa que fuimos responsables del resultado. A los seres humanos les resulta difícil de comprender esta simple verdad: siempre estamos dispuestos a construir una narrativa explicativa donde todo está determinado por causas y efectos directos, y sin incertidumbre. Es como interpretar si movemos el interruptor y enciende una lámpara, generalmente nos consideramos responsables de ello. Pero a veces tus acciones claramente no son responsables de un resultado: si no tomamos un paraguas, y llueve, no nos culpamos, aunque puede parecerlo. Pero las consecuencias de muchas de nuestras acciones son menos claras. Supongamos que tiene dolor de cabeza, tome una aspirina y su dolor desaparece. ¿Cómo sabemos que no habría desaparecido aunque no hubieras tomado una tableta?

Tenemos una fuerte tendencia psicológica a atribuir el cambio a nuestra intervención y esto, provoca el sentido de culpa y sentirnos traicionados. Cadenas de buena o mala suerte no se terminan nunca. Eventualmente las cosas se calman de nuevo, esto también puede ser considerado como regresión media cuadrática, al igual que las estaturas de los hijos dadas por las estaturas de los padres. Pero si creemos que estás en una buen racha, entonces atribuimos por error que es consecuencia normal de nuestras buenas decisiones. Tal vez tiene ramificaciones notables, tales como:

1. Ser despedidos de un trabajo fastidioso y que limita todo nuestro potencial, consideramos en su momento algo malo y triste, para después darnos cuenta de estar en un lugar donde se valora nuestro talento.

2. Al comprar una muy costosa computadora, ir a una universidad de colegiaturas para clases ricas y, al final en la vida profesional darnos cuenta de que ni la tecnología y ni la universidad privada costosa fueron la diferencia, todo cuando vemos triunfar a alguien que tuvo todo adverso pero creyó en la literatura y ser autodidacta.

La suerte juega un papel considerable en la posición laboral y en el progreso al elegir qué libros estudiar. No significa que el patrón de cambios positivos observado no exista, como tampoco que no haya contribución de error residual. Así que si queremos saber el efecto genuino de ciertas cadenas de causales, entonces debemos seguir el enfoque utilizado para evaluar los modelos determinísticos más su contribución aleatoria del medio[24]: pronóstico significante.

La múltiple regresión lineal, es tener muchas variables explicativas. Cada variable explicativa es una categoría conceptual operativa que nos da información sobre el objeto observado. Tener relaciones que no son líneas rectas, sino curvas de patrones distintos de datos y variables de respuesta que no son continuas y proporcionales. Esto nos conduce a generalizar la idea de regresión para más de una variable explicativa. No es necesario ajustar la asignación aleatoria para garantizar cada factor distinto del tratamiento principal, debe equilibrarse de todos modos con un solo factor de error de residuo global a todo el grupo de curvas de regresión.

No todos los datos son mediciones continuas, como la estatura de una población. En gran parte del análisis estadístico, las variables dependientes pueden ser las proporciones de eventos que ocurren o no (por ejemplo, la tendencia de personas que sobreviven a COVID-19), el recuento del números de eventos (tal como el cáncer que ocurre en una área agrícola determinada). Cada tipo de variable dependiente tiene su propia forma de regresión múltiple, con una interpretación correspondiente diferente de los coeficientes estimados. Si bien por lo general se instala una línea de regresión lineal a través de los puntos de los datos, la extrapolación ingenua sugiere tratar un gran número de casos, para pronosticar algo más allá al 100%, lo cual es absurdo. Así que se ha desarrollado una forma de regresión para las proporciones, llamada regresión logística, que asegura que una curva no puede ir por encima del 100% o por debajo del 0[25]%. Este fue un hallazgo controvertido cuando fue publicado en 2001, y ha contribuido a prolongadas disputas sin resolver sobre todo en Inglaterra dentro de la investigación médica.

Los investigadores han adoptado cuatro estrategias principales de modelización:

1) Representar la matemática lo más simple para justificar las asociaciones, como en los análisis de regresión lineal, que tienden a ser favorecidos para los estadísticos.